第二次人工智能浪潮发生在1977—2006年,人工智能的发展有了质的飞跃,许多人工智能技术和应用应运而生。这一时期,人工智能研究者们对以前的研究经验及教训进行了认真的反思和总结,继续迎难而上,迎来了以知识为中心的人工智能蓬勃发展新时期。1977年,爱德华·费根鲍姆(Edward Feigenbaum)的“知识工程”概念引发了以知识工程和认知科学为核心的研究高潮。

首先,我们要介绍的是概率统计模型在人工智能发展中的作用。

概率论是衡量某个随机事件发生的可能性的度量理论。概率统计伴随着概率论的发展而产生,它利用概率论研究随机事件发生的规律,归纳其中的规律。人工智能的首要任务就是对信息进行获取、处理和表达,要完成这些任务,概率统计模型功不可没。概率统计模型在人工智能的发展中主要有以下两个方面的应用。

1.概率逻辑在人工智能中的应用

在20世纪的中期到后期,现代逻辑已经与人工智能息息相关、相互融合。与逻辑相关的理论和技术在人工智能发展中起着十分重要的作用,其能为人工智能提供强大的工具和理论基础。非单调逻辑是人工智能中的一种重要的推理方式,专家系统、机器学习、自然语言处理、智能决策支持体系等均属于该类逻辑下必须了解的主题。基于各种不合逻辑的理由的不确定推理体现出了更多的智能性。

概率逻辑是在现代逻辑的基础上进行概率推理。过去基于概率的不确定性推理方法,如主观贝叶斯方法、确定性理论等,均是为某一命题(或语句)直接赋以一个代表不确定性的概率。该类方法可简单快速地计算知识的不确定性,但其往往与标准的概率论没有清晰明确的联系,缺少数据间的独立性。而概率逻辑利用可能世界将命题和概率联系起来,即一个命题由一个可能世界表示。这些可能世界可为对应命题提供支撑(在二值概率逻辑中,支撑表示为T;在三值概率逻辑中,支撑表示为T或I),对这些可能世界加以概率,则可通过可能世界的概率对命题的概率进行计算。如此一来,概率逻辑与概率论之间形成了明确的联系,并且解决了数据独立性的问题。

人工智能从一开始就与概率逻辑紧密连接,从第一次人工智能浪潮中可以看到,若对某些信息进行分类,则需要学习贝叶斯思维;想通过观察到的样本推断某类对象的总体特征,则需要建立估计理论和大数定理的思想;想识别一段音频,则需要依赖随机过程中的隐马尔可夫模型;想理解近似采样方法,则需要好好琢磨蒙特卡洛算法及马尔可夫过程。在这些例子中,前面是人工智能技术需要解决的问题或想要实现的功能,而后面则是其对应的所需要的概率论知识。

因此,逻辑学中的理论、方法和技术对人工智能的发展有着至关重要的作用。

2.信息论在人工智能中的应用

信息论是运用概率论与数理统计的方法研究信息传输和信息处理系统中一般规律的新兴学科,其核心问题是信息传输的有效性、可靠性及二者间的关系。信息论在人工智能领域中也很重要,由于篇幅关系这里不再赘述。

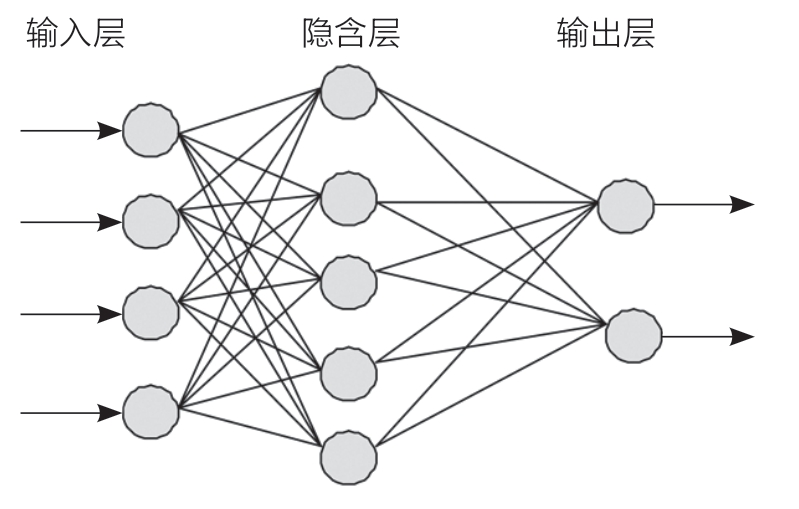

概率统计模型的兴起极大地提高了人工智能应对各种场景的准确性和科学性,解决了很多理论上的问题,而人工神经网络的出现则推动了人工智能的计算和应用。人工神经网络(ANN)是早期机器学习的一种重要方法,是一种用于模拟人脑分析和处理信息的计算系统。神经元是人工神经网络最基本的单元,每个单元都有输入连接和输出连接,神经元相互连接产生了强大的处理能力,模拟了生物的神经系统,相当于机器的大脑中枢。第二次人工智能浪潮的一个显著特点是对人工神经网络进行了更加深入的研究,推动了人工智能在应用层面的发展。

实际上,在第一次人工智能浪潮中就已经提出了ANN的概念了。1957年,弗兰克·罗森布拉特(Frank Rosenblatt)模拟实现了一种叫作“感知机”(Perceptron)的神经网络模型。它只有一层输入层和一层输出层,被称为最简单的前馈式人工神经网络,是一种二分类的线性分类判别模型。但由于当时算力不足,人工神经网络并没有得到进一步发展。

1974年,在哈佛大学保罗·沃伯斯(Paul Werbos)的博士论文里,首次提出了通过误差的反向传播(BP)来训练人工神经网络的观点。简单神经网络示意见图2-5。

图2-5 简单神经网络示意

1982年,约翰·霍普菲尔德(John Hopfield)发明了霍普菲尔德模型,这是循环神经网络(Recurrent Neural Network,RNN)的雏形,该网络解决了一大类模式识别问题,还给出了一类组合优化问题的近似解。霍普菲尔德模型的提出标志着神经网络的复兴,振奋了整个神经网络领域。

1986年,杰弗里·辛顿等人先后提出了多层感知器(MLP)与反向传播训练相结合的理念,开启了人工神经网络学习的高潮。

1989年,LeCun结合反向传播算法与权值共享的卷积神经层发明了卷积神经网络(Convolutional Neural Network,CNN),并首次将卷积神经网络成功应用于美国邮局的手写字符识别系统,正是基于这一成就,LeCun被誉为“CNN之父”。

1997年,Sepp Hochreiter和Jürgen Schmidhuber提出了长短期记忆网络(LSTM),LSTM是一种复杂结构的。

这一时期,尽管人工智能在专家系统、人工神经元网络模型等方面取得了巨大的进展,能够完成某些特定的、具有实用性的任务,但面对复杂问题却显得束手无策,尤其是当数据量积累到一定程度后,有些结果就难以实现改进,极大地限制了人工智能的实际应用价值。因此,人工智能发展到20世纪90年代中期时,相关研究再度陷入困境。

直到2006年,杰弗里·辛顿及学生鲁斯兰·萨拉赫丁诺夫正式提出了深度学习(Deeping Learning)的概念,开启了以深度学习为主要方向的第三次人工智能浪潮。