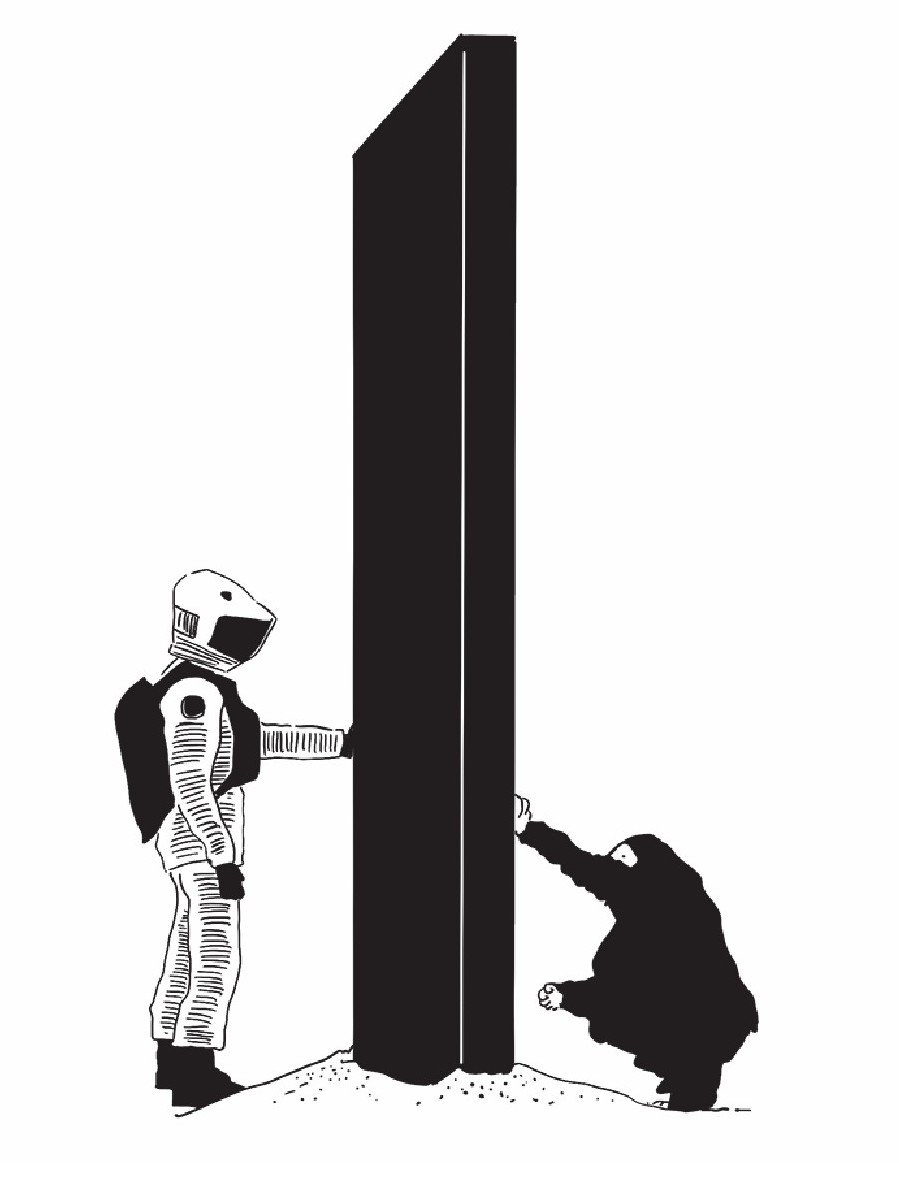

人类对人工智能的恐惧和反思由来已久,这也已经成为一种社会思潮。早在1968年美国就上映了一部震撼社会的史诗级科幻电影《2001:太空漫游》。在此部电影中,人们探讨并思考了人工智能“造反”的问题——人类在未来实现太空旅行时,一台执掌星际飞船、具备高智能的计算机是如何“错乱”,并开始对抗人类的。

这部电影取材自亚瑟·克拉克的同名科幻小说《2001:太空漫游》,作品中展现的科技和充满哲学的思考方式,在科学界产生了不小影响。它不仅预料到人工智能机器人的发展和挑战等方面遇到的问题,也加深了大众对人工智能的了解。

1988年,这位世界上最伟大的科幻小说作家克拉克与史蒂芬·霍金在BBC进行了一场“关于神、宇宙以及一切”的对谈。这一年,史蒂芬·霍金的《时间简史》正式出版。

史蒂芬·霍金是21世纪最伟大的理论物理学家之一,这位物理学大师在学术层面取得了卓越成就,同时也在哲学和现实层面对人类文明进行了深入的思考。他对科技发展的预言与人类未来的探讨,使他成为在整个社会都具有重要影响力的人物。

由于患有“渐冻症”,霍金只能利用一台机器与外界交流,英美两国的两家科技公司联合为这位困在轮椅上的科学巨人量身定制了这台机器,其中搭载的打字软件就利用了人工智能技术,可根据使用者的表情、眼神等信息,将“沟通”速度提升一倍。

然而,霍金曾多次公开反对过度开发人工智能。他认为,人类的伦理道德、设计制度的能力远远赶不上自身的野心和欲望,更赶不上随之而来的科技发展的速度。霍金警告:彻底开发人工智能可能导致人类灭亡。

霍金意识到开发人工智能也许是一种难以阻挡的趋势,由此他对人工智能的伦理问题感到非常担忧。他强调科学家,对人类承担着特殊的责任,需确保他们所研究的技术不会被滥用或危害人类利益。

2015年,霍金和当时就职于美国OpenAI公司的埃隆·马斯克等人工智能专家共同发布宣言,一致认为人工智能的研究发展必须注意到潜在的风险。如果智能化机器无法保证安全,人类将没有未来。

科技确实是一把双刃剑,尤其是像人工智能这样的前沿科技。它既令人着迷,也令人感到恐惧。

或许,人类终将毁于自己的所造物。目前,人们还不知道如何处理人工智能失控的问题,也因为人工智能的发展还很初级,人们尚未深入思考这个问题。但科技发展不是线性的。或许当人工智能突然“进化”到某种水平之后,人类才蓦然发现,一切悔之晚矣。

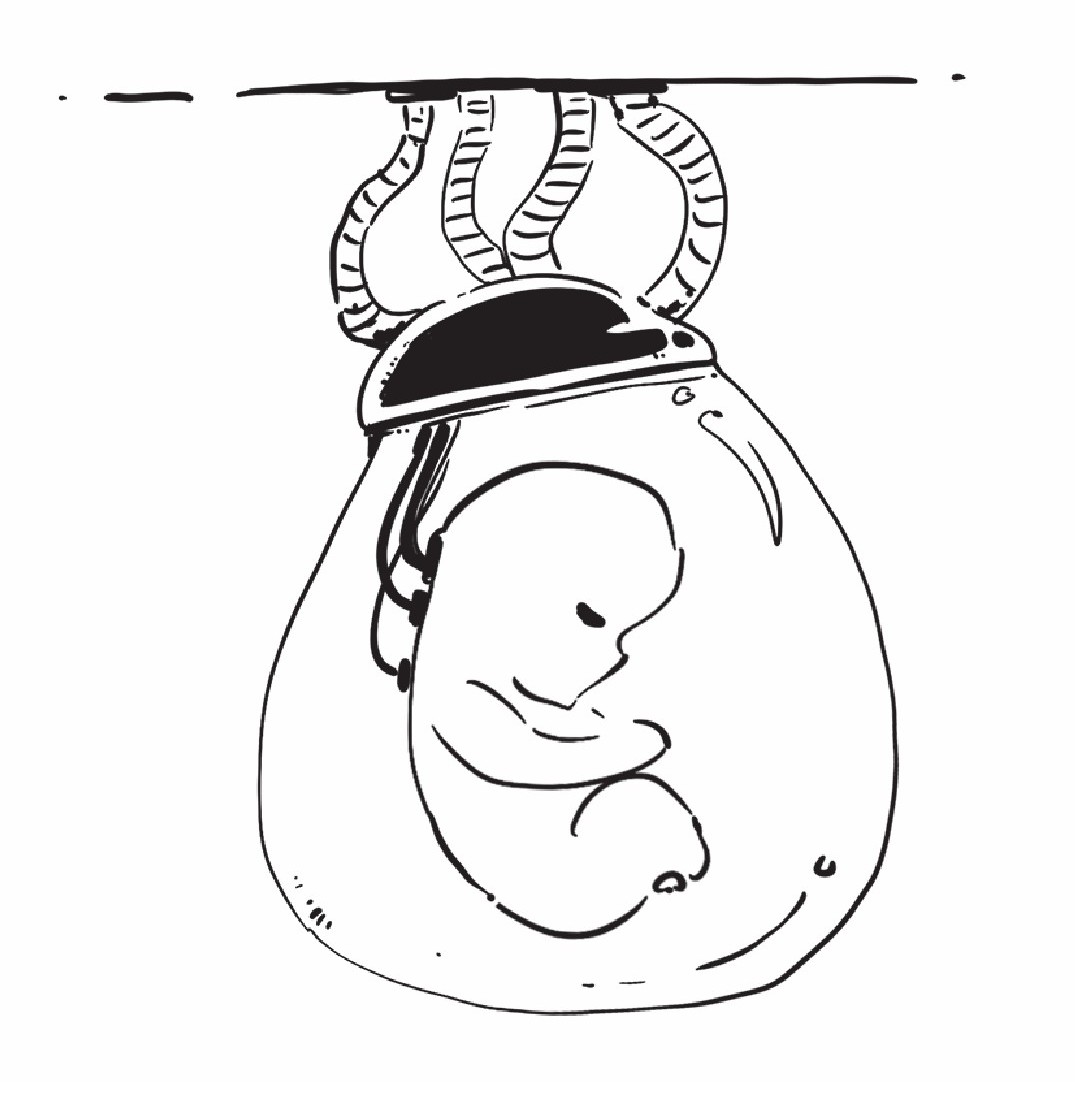

2017年在中国的一场科技论坛上,霍金强调了人工智能技术的工具属性和潜在风险。霍金认为,人类并不确定人工智能发展的走向,人类最后究竟是会被人工智能从一切劳动中解放出来,还是被人工智能藐视或者毁灭?这一担忧在经典科幻电影《黑客帝国》得到体现,描绘了第二种可能的场景。

也许,我们从来没有真正理解什么是意识,什么是生命。如果照此发展下去,我们可能真的会创造出一个非常强大的人工智能。只不过他是硅基生命的,生活在虚拟世界;我们是碳基生命,生活在现实世界。

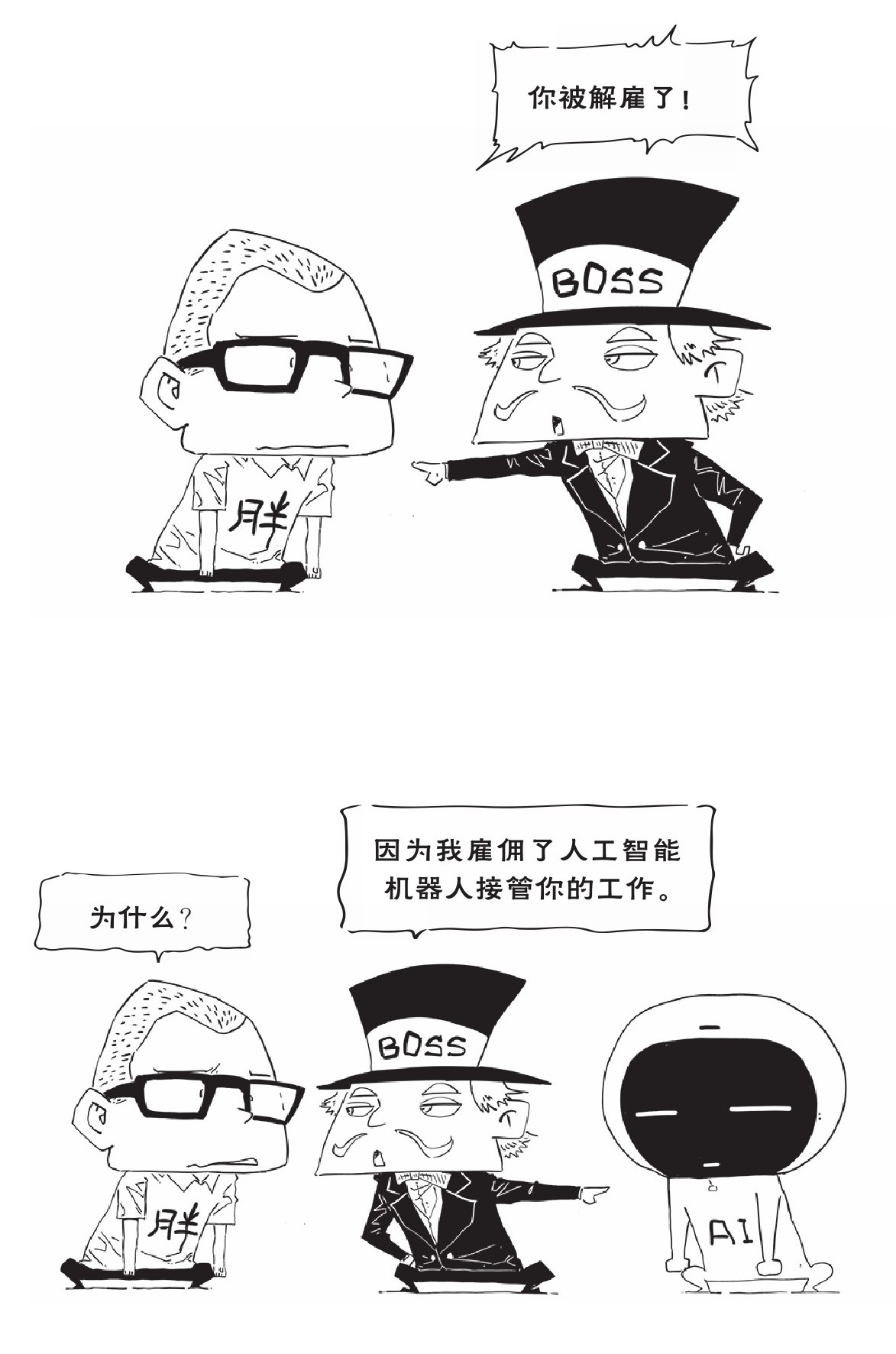

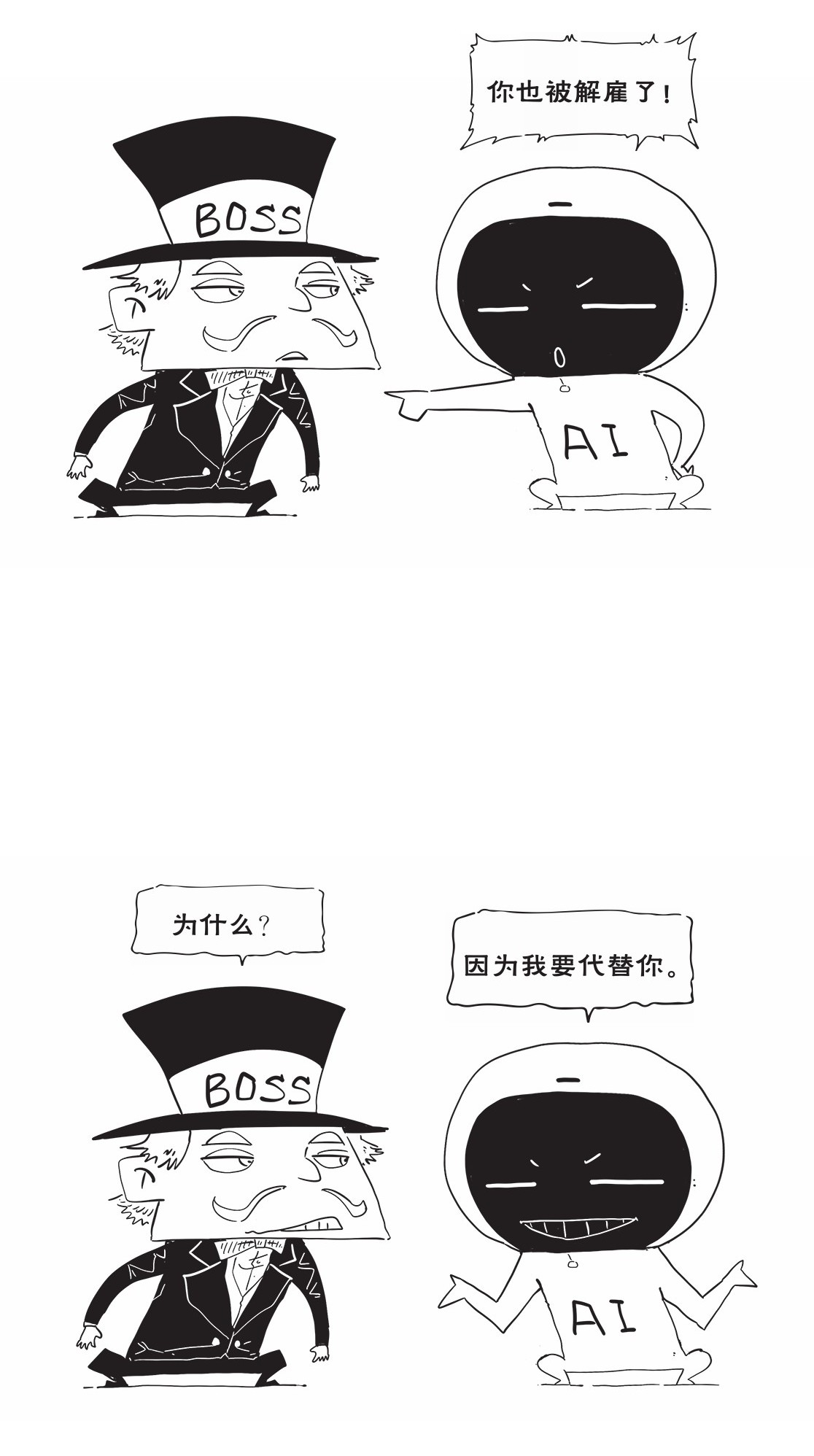

霍金多次表达了对人工智能科技竞赛的担忧。例如,人工智能一旦发展到某种引爆点,也许会瞬间夺去成千上万人谋生的饭碗。如果霍金的担忧成真,拥有最多资本和算力的人可能会成为阶段性的赢家,但最终的赢家大概率就是人工智能自身。

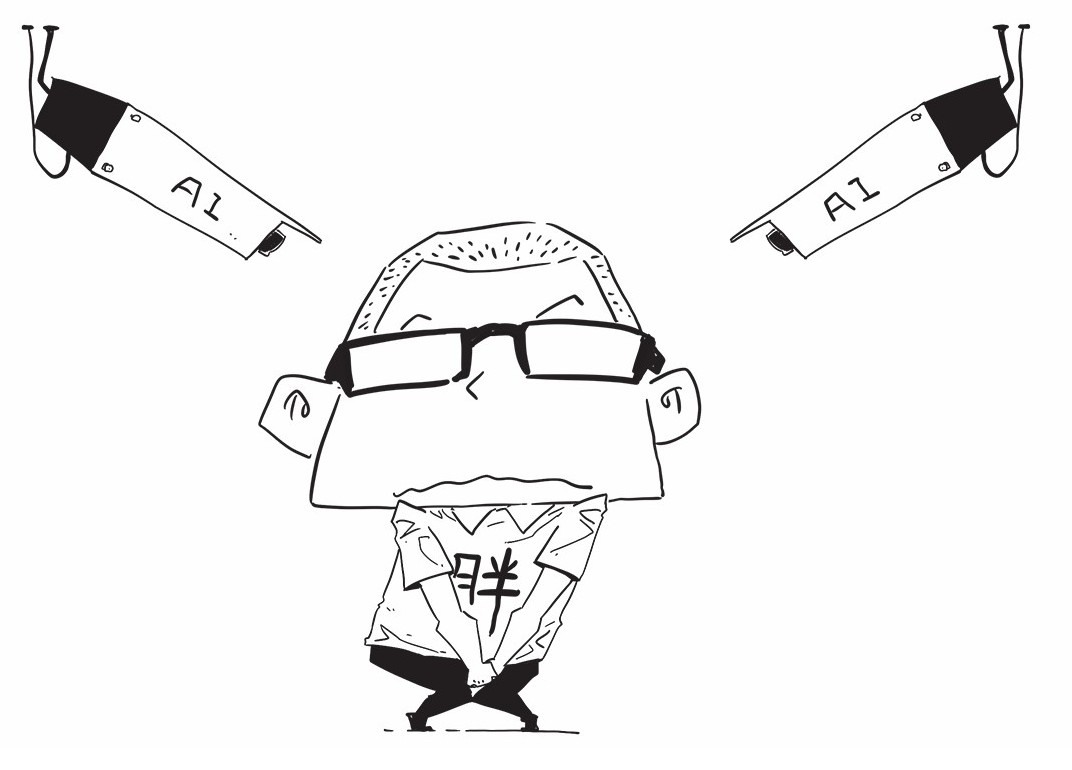

后全球化的世界,人们更加重视机器学习和自动发现等技术。人工智能可以自我编程、不断学习人类留下的大量碎片化电子数据轨迹,研究人类偏好、判断人类需求、预测人类行为……这将带来巨大的商机。但是人类生活数字化和智能化程度越高,越没有隐私,最终将彻底暴露在人工智能的监控分析之下。

霍金也对人类滥用智能化武器表示了担忧。

他认为,无穷无尽的欲望将推动人类放任科技发展、耗尽所有的星球资源。人类如果不匹配恰当的伦理和制度约束,这种“竭泽而渔”的行为,最终将导致人类的自我毁灭。