在上一讲中,我们主要考察的,乃是符号AI的理论基础——形式逻辑——以及其在分析哲学中的根苗,并对现代形式逻辑对于AI研究的指导价值做出了一种悲观的评估。而在本讲中,我们将考察AI研究中的另一大流派:联结主义,及其直接的技术后承者:深度学习(顺便说一句,当前在一些文献中,已有将“联结主义”与“深度学习”这两个名目交换使用的倾向)。但与当前社会各界的对于深度学习技术的高度期待不是,我认为深度学习并非AI研究的真正康庄大道。而这一判断又是基于如下观察的:深度学习机制的根底,乃是对于人类专家某方面的数据归类能力的肤浅模仿——此类机制正是在这种模仿的基础上,才能在某类输入信息与某类目标信息之间建立起特定种类的映射关系。而之所以说此类技术对于人类能力的模仿是“肤浅”的,又恰恰是因为深度学习机制的运作完全是以大量人类专家提供大量优质的样板数据为逻辑前提的;与此同时,这种模仿却又不以深入理解人脑对于信息的内部加工过程为自身的理论前提,故天生就带有“知其然而不知其所以然”之弊。如此一来,在人类专家无法提供大量样板数据的地方,深度学习机制自然很难有用武之地——而“智能”之为“智能”的标志之一却恰恰在于:配称“智能”者,能够在前人没有全面涉足的领域,做出创造性的贡献。

由此出发,我们甚至可以从深度学习机制的本质特征出发,归结出其大规模运用对于人类文明所可能造成的潜在威胁:

第一,刚才已提到,深度学习对于大量数据信息的处理过程,在原则上就是在某些输入信息与某些目标信息之间建立起特定种类的映射关系的过程。在这种情况下,某些掌握数据调配权限的人类训练员完全可以通过对于训练目标的人为调控,来控制系统的数据归类方向,由此固化人类自己的某些偏见(比如在人脸识别系统中对于具有某种面部特征的人群的“犯罪倾向”的归类),最终造成负面的伦理后果,威胁到人类文明的多样性。这个问题也被称为“算法偏见问题”。

第二,与基于规则的人工智能不同,基于数据采集的深度学习系统本身的运作是很难通过线性的公式推导过程而在人类语言的层面上被解释的,其结果更像是某种神秘的“黑箱”运作后的输出结果。在这种情况下,即使是系统的设计者,有时候也说不清楚为何系统会在某些运行条件下给出这样的运算结果。由于这种非透明性,此类人工智能系统若被纳入以“说理”为基本交流方式的人类公共生活之中,自然就会导致与人类既有社会习俗与法律系统的大量碰撞。这个问题也被称为“算法透明性问题”。

第三,深度学习系统的大量运用会在短期内对特定领域内的人类工作岗位构成威胁,由此也会对人类专家的稳定培养机制构成威胁,并使得深度学习未来的智慧汲取对象变得枯竭。由此,滥用深度学习技术的人类社会,在吃光该技术所能带来的短期红利之后,可能最终会走向文明的衰落(这一威胁,将在本讲第二节中得到全面的展示)。

而为了佐证如上的判断,在本节中,我就将通过深度学习机制与人类智慧的比较,来看看究竟在哪些地方前者是比不上后者的。

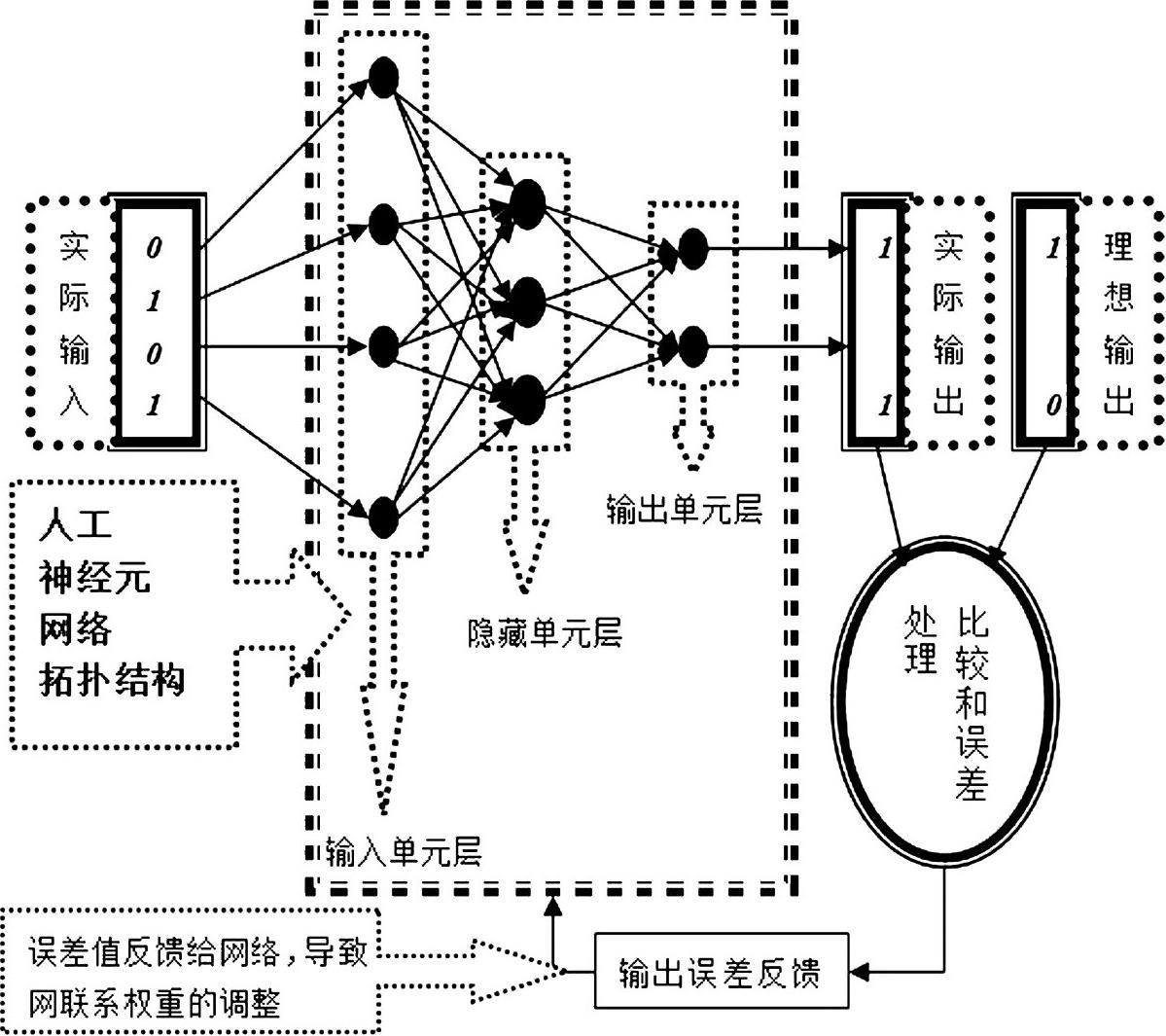

从技术史的角度看,深度学习技术的前身,其实就是在20世纪80年代就已经热闹过的“人工神经元网络”技术(也叫“联结主义”技术)。该技术的实质,便是用数学建模的办法建造出一个简易的人工神经元网络结构,而一个典型的此类结构一般包括三层:输入单元层、中间单元层与输出单元层(如图3-1所示)。输入单元层从外界获得信息之后,根据每个单元内置的汇聚算法与激发函数,“决定”是否要向中间单元层发送进一步的数据信息,其过程正如人类神经元在接收别的神经元送来的电脉冲之后,能根据自身细胞核内电势位的变化来“决定”是否要向另外的神经元递送电脉冲。需要注意的是,无论整个系统所执行的整体任务是关于图像识别还是自然语言处理的,仅仅从系统中的单个计算单元自身的运作状态出发,观察者是无从知道相关整体任务的性质的。毋宁说,整个系统其实是以“化整为零”的方式,将宏观层面上的识别任务分解为系统组成构件之间的微观信息传递活动,并通过这些微观信息传递活动所体现出来的大趋势,来模拟人类心智在符号层面上所进行的信息处理进程。工程师调整系统的微观信息传递活动之趋势的基本方法如下:先是让系统对输入信息进行随机处理,然后将处理结果与理想处理结果进行比对,若二者彼此的吻合度不佳,则系统触发自带的“反向传播算法”来调整系统内各个计算单元之间的联系权重,使得系统给出的输出能够与前一次输出不同。两个单元之间的联系权重越大,二者之间就越可能发生“共激发”现象,反之亦然。然后,系统再次比对实际输出与理想输出,如果二者吻合度依然不佳,则系统再次启动反向传播算法,直至实际输出与理想输出彼此吻合为止。而完成此番训练过程的系统,一般也能够在对训练样本进行准确的语义归类之外,对那些与训练样本比较接近的输入信息进行相对准确的语义归类。譬如,如果一个系统已被训练得能够识别既有相片库里的哪些相片是张三的脸话,那么,即使是一张从未进入相片库的新的张三照片,也能够被系统迅速识别为张三的脸。

图3-1 一个高度简化的人工神经元网络结构模型(资料来源:笔者自制)

如果读者对于上述的技术描述还有点似懂非懂的话,不妨通过下面这个比方来进一步理解人工神经元网络技术的运作机理。假设有一个外国人跑到少林寺学武术,那么,师生之间的教学活动到底该如何开展呢?这就有两种情况。第一种情况是:二者之间能够进行语言交流(譬如,少林寺的师父懂外语),这样一来,师父就能够直接通过“给出规则”的方式教授他的外国徒弟。这种教育方法,或可勉强类比于符号AI的路数。第二种情况则是:师父与徒弟之间语言完全不通,在这种情况下,学生又该如何学武呢?唯有靠这个办法:徒弟先观察师父的动作,然后跟着学,师父则通过简单的肢体交流来告诉徒弟,这个动作学得对不对(譬如,如果对,师父就微笑;如果不对,师父则对徒弟棒喝)。进而言之,如果师父肯定了徒弟的某个动作,徒弟就会记住这个动作,继续往下学;如果不对,徒弟就只好去猜测自己哪里错了(注意:因为师徒之间语言不通,徒弟是不能通过询问而从师父口中知道自己哪里错了),并根据这种猜测给出一个新动作,并继续等待师父的反馈,直到师父最终满意为止。很显然,这样的武术学习效率是非常低的,因为徒弟在胡猜自己的动作哪里出错时会浪费大量的时间。但这“胡猜”二字却恰恰切中了人工神经元网络运作的实质。概而言之,这样的AI系统其实并不知道自己得到的输入信息到底意味着什么——换言之,此系统的设计者并不能与系统进行符号层面上的交流,正如在前面的例子中师父无法与徒弟进行言语交流一样。毋宁说,系统所做的事情,就是在各种可能的输入与输出之间的映射关系中随便选一种进行“胡猜”,然后将结果抛给人类预先给定的“理想解”,看看自己瞎蒙的答案是不是恰好蒙中了。如果真蒙中了,系统则会通过保存诸神经元之间传播路径权重的方式“记住”这蒙中的结果,并在此基础上继续“学习”。而这种低效学习的“低效性”之所以在计算机那里能够得到容忍,则是缘于计算机相比于自然人而言的一个巨大优势:计算机可以在很短的物理时间内进行海量次数的“胡猜”,并由此遴选出一个比较正确的解,而人类在相同时间能够完成的猜测的数量则会是非常有限的。但一旦看清楚了里面的机理,我们就不难发现:人工神经元网络的工作原理其实是非常笨拙的。

读到这里,有的读者或许会问:为何现在“人工神经元网络”或者“联结主义”被称为“深度学习”呢?“深度”这个定语又是什么意思呢?

不得不承认,“深度学习”是一个非常容易误导人的名目,因为它会诱使很多外行认为眼下的AI系统已经可以像人类那样“深度地”理解自己的学习内容了。我个人比较赞成将“深度学习”称为“深层学习”,因为后者也可以完美对应该词的英文原文“deep learning”(顺便说一句,日本计算机学界就是用“深層学習”这个汉字表达式来对应“deep learning”的。甚至也有一些日语文献不将该英文词汇汉字化,而是直接将其音译为片假名表达式“ディープラーニング”)。那么,为何“深层学习”这个表达在学理上更准确呢?因为“deep learning”技术的真正含义,就是以如下方式将传统的人工神经元网络进行技术升级:即大大增加其隐藏单元层的数量(比如,从图3-1中所呈现的一到两层,暴增到上百层。不过,若将标准放宽,四层以上的中间层也可以算作是“深层”了)。这样做的好处,便是能够大大增加整个系统的信息处理机制的细腻度,使得更多的对象特征能够在更多的中间层中得到安顿。比如,在人脸识别的深度学习系统中,更多的中间层次能够更为细腻地处理初级像素、色块边缘、线条组合、五官轮廓等处在不同抽象层面上的特征。这样的细腻化处理方式当然能够大大提高整个系统的识别能力。但需要看到的是,由此类“深度”化要求所带来的整个系统的数学复杂性与数据的多样性,自然会对支撑其运作的计算机硬件以及训练用的数据量提出很高的要求。这也就解释了为何深度学习技术本身是在21世纪后才逐渐流行起来的——因为正是最近十几年以来计算机领域内突飞猛进的硬件发展,以及互联网的普及所带来的巨大数据量,才为深度学习技术的落地开花提供了基本的保障。

不过,尽管深度学习技术已经在很多应用领域获得了很大成功,但是很难说相关产品的行为表现已经达到——甚至接近达到——人类智能的水平。深度学习技术与人类自然智慧之间的差距体现在如下两个方面:

第一,深度学习系统的设计虽然在原理上参照了人类神经元网络的结构,但略去了大量的生物学细节,而且在复杂程度上与真正的人脑也不可同日而语。需要注意的是,一些深度学习的倡导者主张人类某些神经元的微观结构实际所采用的信息处理程序非常类似于深度学习的算法。但即使这一发现是有意义的,也恰恰说明人类大脑的实际复杂程度远远超过了现有的深度学习系统(理由是:若你发现你的模拟对象的一个微观部分的复杂程度与你的模拟系统自身大致相当的话,那么按照“整体大于部分”的原理,你就应当推理出:你的模拟对象的整体复杂度远远超过了你所设计的模拟系统)。而我们由此不难立即推出:既然现有的深度学习系统在复杂程度上远远不如人脑,那么,我们也就不能期望这样的系统能够完全地具备人类的智慧。

第二,深度学习技术不仅目前不是通用智能系统(即能够在用户干预最少化的情况下完成各种任务的智能系统),而且在原则上也无法成为通用智能系统。与之相较,人类的心智系统肯定是通用智能系统(也就是说,一个智力正常的自然人通常能够在外部干预相对稀少的情况下,自主完成从一项任务到另一项任务的切换)。对于这一点,可能有些读者会产生疑虑,因为深度学习的算法基础并不是针对一个特定的问题领域的,而是能够在原则上适用于各种应用场景的(如自动言语识别、图像识别、金融诈骗检测,等等),因此,上文对于深度学习技术的这一批评,似乎不太公平。但需要注意的是,“能够在原则上运用于各种应用场景”的算法,并不一定就是符合通用人工智能要求的算法。至于深度学习技术之所以无法满足该要求,则进一步因为:虽然该技术本身具有普遍的适用性,但是已经运用了深度学习技术的特定产品却肯定是专用的——譬如,以图像识别为主要任务的深度学习系统,其在神经元网络构架与反向传播算法的设计的细节方面,肯定与以自然语言处理为主要任务的深度学习系统非常不同。换言之,一旦一个深度学习系统已经完成了以特定任务为指向的训练,它就不能同时胜任另外一个领域的工作了(这就好比说,一套被拼装为埃菲尔铁塔的模型的乐高玩具,是很难再被拆碎后重新拼装为山海关的模型了)。而与之相比照,一个人类的医学专家所具有的自然通用智能,却使得他在医学领域之外,能照样擅长做家务、下棋、开汽车、打篮球等彼此差异很大的任务。

有的读者或许还会说,虽然大量特定领域内的深度系统只能执行特定的任务,但是,对于此类模块的大量集成却可以在未来的某个时间点促成通用人工智能系统的构成。那么,我们该怎么回应这种意见呢?在笔者看来,尽管从非常抽象的角度看,这个可能性的确不能被排除,但是基于如下考量,这种可能性依然是不太可能在单纯的深度学习路径中实现的。原因如下:对于复杂系统的集成显然是需要某种“顶层设计”的,而当前受到特定应用场景激发的不同深度学习项目则是各自为政,彼此缺乏协调的。而反过来说,如果深度学习的研究者需要从事这种顶层设计的话,他们就不得不面对笔者后面将提到的“如何实现中立于特定经验的一般推理”这个问题,而该问题本身则非常可能迫使研究者脱离深度学习的既有技术路线。对此,本书下一讲在正面讨论“通用人工智能”时还会详谈。

还有的读者或许会指出:在“迁移学习”的名目下,不少研究者已经在探索如何将已经适应某种特定任务的深度学习系统的学习经验,“迁移”到另一个问题领域中去。因此,现在就断言深度学习系统无法成为通用智能系统,似乎还尚显仓促。但是,基于如下理由,我还是认为“迁移学习”的发展潜力是有限的:

(1)目前最常用的迁移学习方法,是先识别出源领域与目标领域中共有的特征表示,然后再利用这些特征进行知识迁移。但是,实施这一做法的前提条件是:源领域与目标领域各自的特征在微观层次上必须足够彼此类似,而这一点在原则上就使得迁移学习的适用范围受到了很大的限制。而与之相比较,人类的类比思维能力却可以支持人类在微观层次特征相距遥远的两个领域内进行知识迁移——比如将讨论军事斗争的《孙子兵法》中的某些原则沿用到商战领域内去。

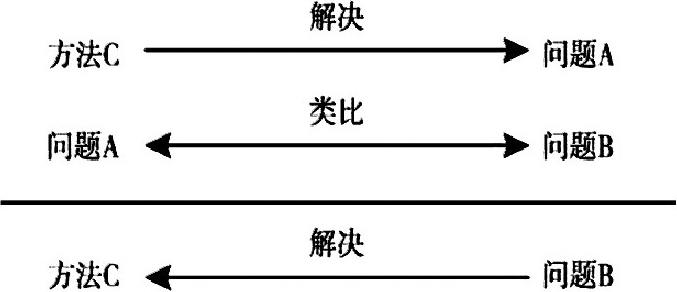

(2)上文提到的人类的类比思维能力本身其实是一种推理能力,其基本推理模式如图3-2所示。

图3-2 人类类比思维的推理模型

然而,任何一种基于深度学习机制的AI系统却不可能是任何一种推理系统,因为任何一个推理系统都应当能够体现出对于被推理内容的起码的中立性与抽象性(在某些理想情况下,比如在三段论推理的“芭芭拉式”中,推论的有效性,完全是与推理所牵涉的小项、中项与大项的经验语义无关的,而只与这些要素在大前提、小前提与结论中的排列位置有关。请参看上一讲的讨论)。但不幸的是,任何能够投入运用的深度学习系统,一旦经过特定领域内样本的训练,就会成为相关领域(或与之底层特征足够近似的领域)内的奴隶,而无法成为某种中立于各个特殊领域的一般推理机制。这一点之所以会成为深度学习的“宿命”(而不是某种通过特定的工程学技巧可以被克服的暂时性困难),则又是缘于深度学习的本质:它们能够做的,只不过是在经过特定的训练过程之后,将具有特定特征的输入归类为人类语义网中的一些既定标签,而不能在符号层面上直接表征人类的各种逻辑或概率推理规律。

从本节的讨论来看,现有的深度学习机制与人类的自然智慧之间的确存在着巨大的差距。用隐喻化的语言来说,这种AI系统的工作原理虽然貌似模仿了人脑的神经元网络,但它既缺乏人类心智系统的高阶构建(譬如对于大尺度神经回路与不同脑区之间协同关系的构建),也缺乏对于神经元运作的一些更微观细节的模拟。这就好比是一个粗心的观察家对于一个陌生国度的法制状况的描述:这种描述既在宏观层面上抓不住被观察国的宪政精神,又在微观层面上抓不住基层执法活动的细节,而只能抓住“有多大比例的犯罪嫌疑人被指控后的确得到定罪”这样肤浅的中层信息。通过这样的片面信息,一个观察家是很难在另外一个国度中复制被观察国的法制体系的。

但有的读者或许还会发问:仅仅从这样一个结论出发,我们又如何能够得出“深度学习机制会对人类的文明构成长远威胁”这一推论呢?一种明显不如人类智慧的机器的出现,难道不是至多只能成为人类智力的补充吗?而如果我们硬要说“作为人类智慧之补充的深度学习机制是人类文明的威胁”的话,那么,按照同样的逻辑,我们不是也有理由说“便携式计算器也是人类文明的威胁”吗?笔者将在下节中回答这一问题。