由于20世纪末计算机的硬件水平有限、运算能力不足,加上当时数据采集困难,这就导致当神经网络的规模(层数和节点数)增大时,BP神经网络算法就会出现“梯度退化”问题,而且也出现了模型过拟合现象,即给定的网络算不了或者算不好。随着技术的进步,近年来,计算机算力得到了飞速发展,在数据采集方面也有了大量积累。因此,随着网络层数的不断加深,神经网络又一次焕发青春。深度学习方法孕育而生,并被广泛地应用到各个领域。事实上,深度神经网络不仅是加深的神经网络,而且也具有自身的一些特征。下面我们将介绍深度神经网络的一般机理,并给出几种常见的深度神经网络构架。

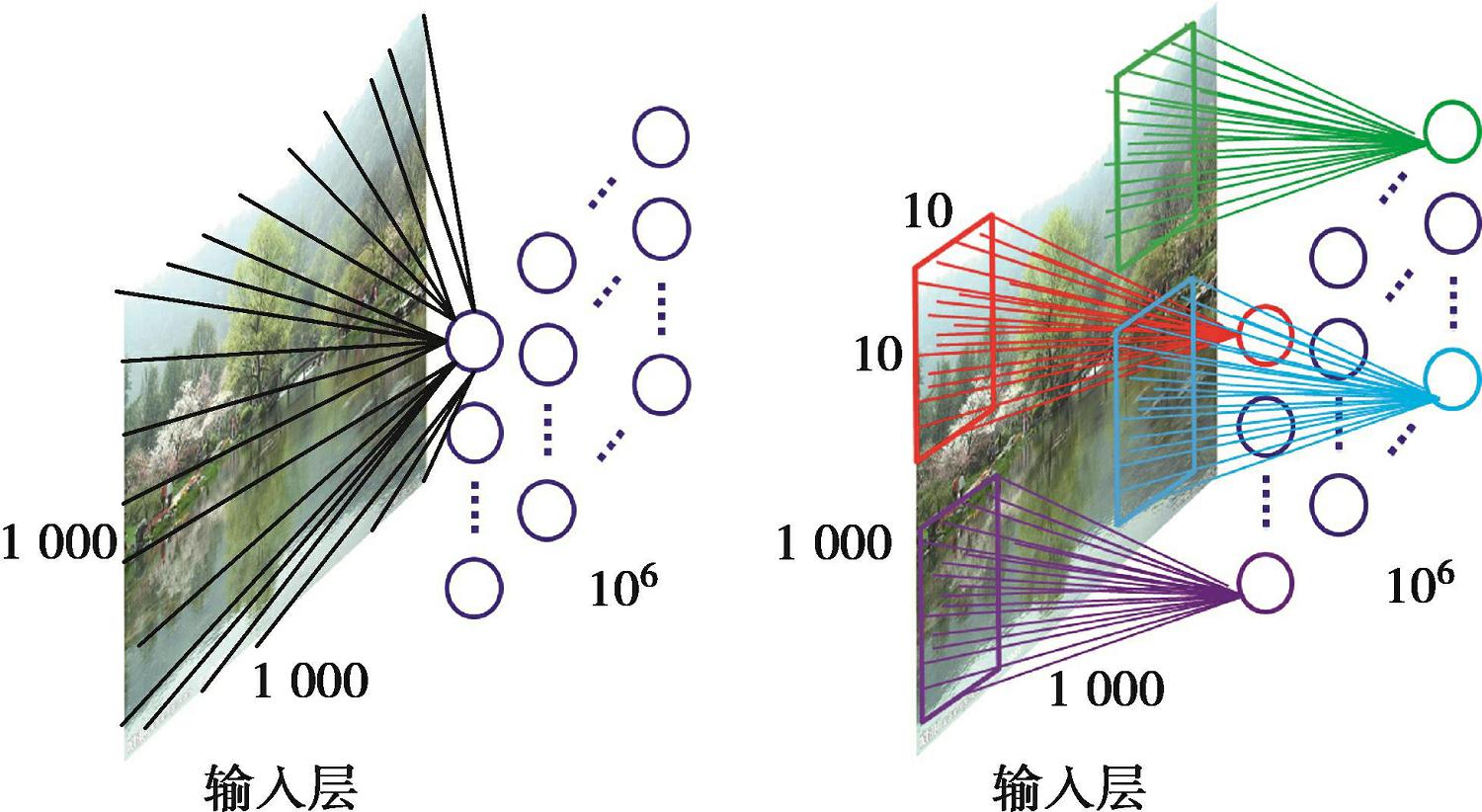

深度神经网络仍然是一个神经网络,因此继承了神经网络的一般理论。但由于网络层数深以及每层节点多的特点,产生了海量的网络参数。例如,图2-3-1给出了一张1 000×1 000大小的图像在输入层的表达。其中,左图是将图像中每个像素作为每个人工神经元的输入,因此输入层有10 6 个人工神经元,且将产生10 12 个连接权重。这对于计算机的存储和计算都是一个非常大的挑战。为了提高网络的学习效率,研究者从视觉感知的机制出发设计了如右图所示的卷积结构。每个神经元只感知图像中10×10的区域,10 6 个神经元各司其职,这样在输入层产生的连接将只有10 8 个,实际储存的权重数目仅有100个,这远远低于全连接的情形。

图2-3-1 深度神经网络中的卷积结构

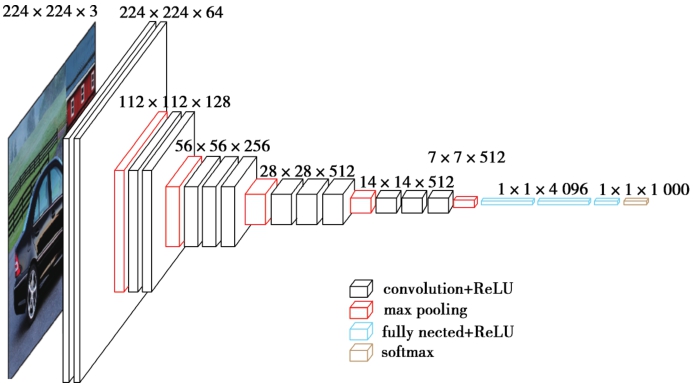

之后,如图2-3-2所示,和多层神经网络一样,将上述的卷积过程串联成一个深度结构,形成一个深度神经网络构架。进一步,通过误差的反向传播对网络的海量连接权重和阈值等网络参数进行优化,从而确定一个能够最优描述输入与目标输出间映射关系的物理模型。

最后,我们介绍两种常见的深度神经网络构架。事实上,深度神经网络提供了一个很好的结构化和模块化设计思路。

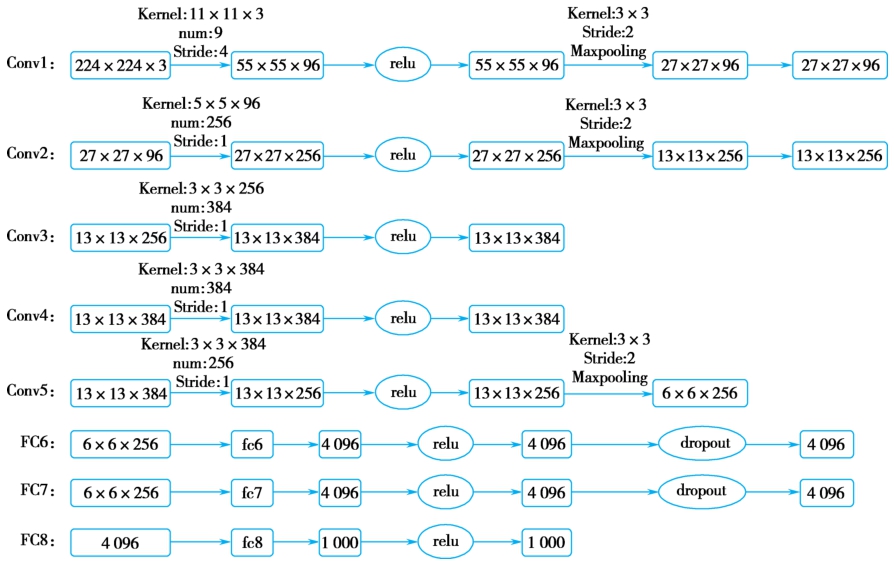

AlexNet模型在2012年ILSVRC(ImageNet大规模图像识别竞赛)比赛中获得了第一名。AlexNet网络构架如图2-3-3所示。

其中,第一层输入图像尺寸是224×224×3,这表示长宽是224个像素,且拥有RGB三个通道。然后采用了96个11×11×3的卷积核,在步长(stride)为4的设置下对输入图像进行卷积操作。进行卷积操作后,输出变成了55×55×96的张量。其中,根据公式“输入张量的尺寸减去卷积核尺寸/步长+1”可以计算得到输出张量的尺寸。然后经过ReLU激活函数和滤波器大小为3×3,步长为2的池化操作,得到输出尺寸为27×27×96的张量。

图2-3-2 深度神经网络构架示例

图2-3-3 AlexNet的分层结构

第二、三、四、五层操作基本类似。第六层的输入是6×6×256大小的张量,将其转化成一个列向量 X ,长度为9 216(6×6×256),也就是看成一个9 216×1的矩阵,然后用 W (4 096×9 216)和 X 相乘,得到了尺寸为4 096×1的矩阵。第七层和第六层操作类似。第八层的输出为1 000×1,即1 000维列向量,对应softmax后的1 000个标签。

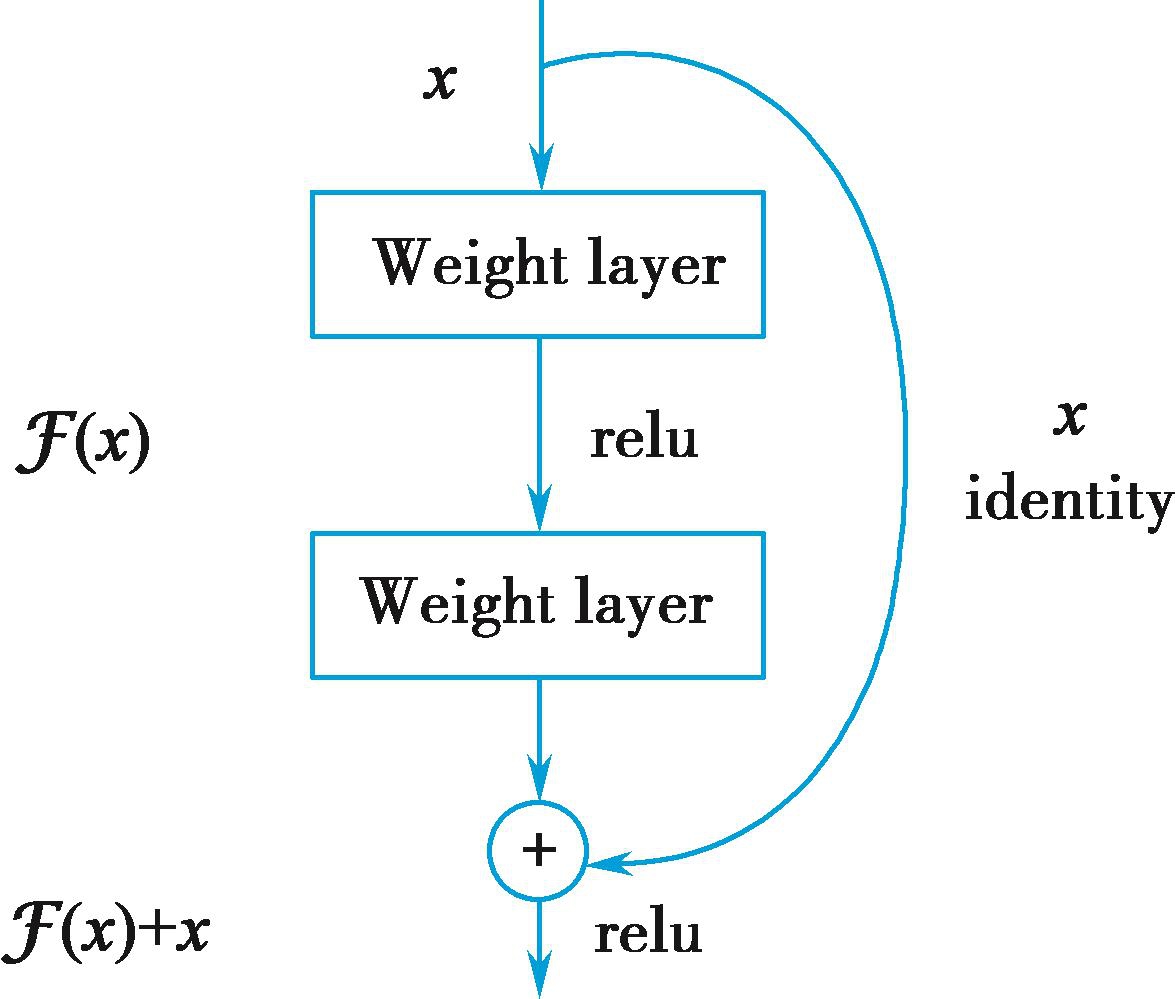

随着各种模型的推陈出新,研究人员发现,虽然增加网络的深度可以让网络具有更好的表征能力,但是这也带来一些问题:随着深度的增加,训练会愈加困难。这主要是因为在基于随机梯度下降的网络训练过程中,误差的多层反向传播非常容易引发梯度退化或者爆炸现象。虽然这样的问题可以由权重初始化策略和批规范化策略等方法加以改善,但是随着网络层数的增加,训练的误差没有降低反而升高了。最终,残差网络(ResNet)的出现解决了这个问题。

残差网络基于残差模块。残差模块的构架如图2-3-4所示。残差网络和一般的网络模型的区别是在做完卷积和池化之后又和初始的输入进行逐项相加或者相乘。此外,残差网络以全局平均池化层代替全连接层,一方面使参数大大减少,另一方面降低了过拟合风险。

图2-3-4 残差模块结构图

(应时辉 彭亚新 孔德兴)