蔡清

上海交通大学生命科学技术学院2002届本科校友,华东师范大学心理与认知科学学院教授,华东师范大学儿童脑成像中心主任。

人工智能是一门交叉学科,随着人工智能在越来越多的领域产生价值,它作为交叉学科的魅力也在逐渐彰显。这种交叉让大家能够看到不同的研究思路和方向,也帮助我们产生新的灵感和思想火花。本文将从语言这一智能的代表产物出发,带领大家探索人脑与人工智能背后的故事。

认知科学是什么呢?它是一个跨领域、非单一的学科。所以我们可以看到除了大家平时解读为脑科学、神经科学的部分,它其实很大程度上也包括了语言学、人工智能和科学哲学等部分。从我的研究方向而言,我主要关注认知神经科学中的语言研究。大概20年前,我在求学阶段就经常被朋友们问一个问题:认知科学可以回答什么问题,又有什么实际作用?

在回答这个问题之前,我先举一个“看图说话”的例子。要解决“看图说话”这样的问题,首先要识别图片中的物体和场景,然后基于图像识别的结果进行语言描述。在过去的这些年中,联结图和文字的方法主要是基于带文字标注的图片去进行学习。这样的方法基于大数据驱动,它整个架构和计算,和人脑的结构与运作原理非常不一样。

那么,人类婴儿是如何学习词汇的呢?其实非常有意思,比如我拿起一个杯子,在一个小孩面前晃一晃说“看,杯子”,然后他可能会伸出小手摸一摸这个杯子。如此反复,几次之后,他可能就完成了对“杯子”这个词汇的学习。在这个过程中,从认知和发展的角度来说发生了三件重要的事情。

第一件事情,就是我会拿一个东西在他面前晃一晃,为什么需要晃一晃呢?如果对成年人说“看”,大家往往就会顺着我的手看过去,哪怕只是默默地往这个方向看。大家会不由自主地想“那边发生什么事情了”,进而会跟着看过去,我们称这种能力为“联合注意”。然而,婴儿在4~6个月以前,基本还不具备这种能力,他不会主动跟随你的目光或手势,所以我们拿物品在他面前晃一晃,是为了直接吸引他的注意力。第二件事情,是在儿童早期语言学习中非常重要的“此时此地”原则,就是当儿童的注意力集中在某个事物上,他听到我们在讲某个特定的词,他看到这个东西,甚至还摸了摸它,他可以把这件事情的对象和当下的感知关联起来。第三件事情,就是多模态整合。婴儿会把看到、听到、摸到的信息整合在一起用来构建认知。这三件事情其实就是认知科学研究的内容,把认知过程的核心能力、行动和原则进行细化和分析。

因此,从认知科学的角度,当前的人工智能和人类语言最大的不同,还是在于人工智能需要大数据驱动。而绝大多数人类,哪怕是婴儿都只需要非常小的数据就可以完成认知和学习,但今天的人工智能算法还很难基于小数据完成学习任务。

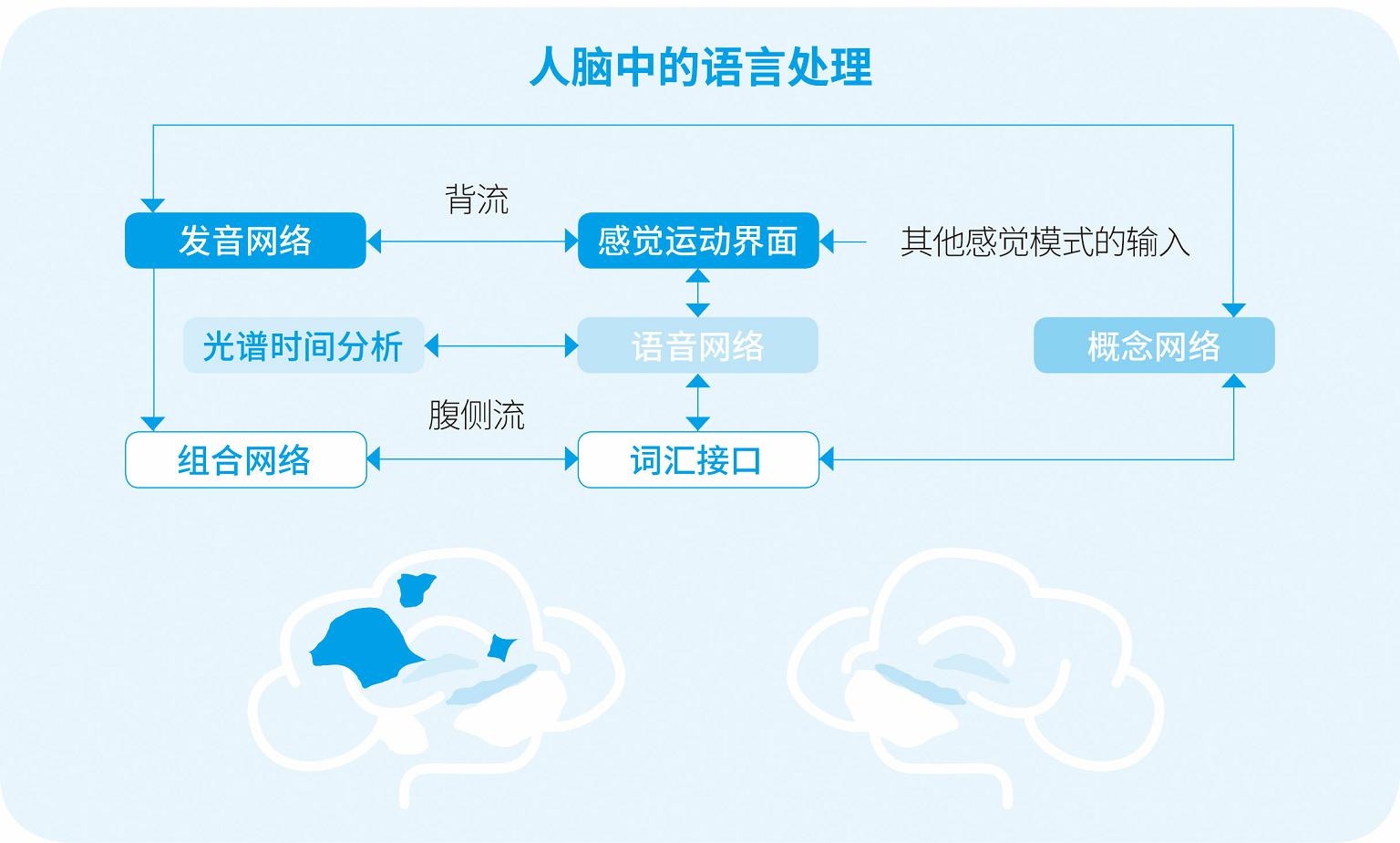

图1是目前比较主流的人脑中语言处理的模型。从这个模型里面可以看到,它包括背侧通道(dorsal stream)和腹侧通道(ventral stream),分别负责不同的事情。一方面,我们会从背侧通道中把感觉运动的信息整合起来,简单说就是把你听到的音、你要说的音的表征统一起来。另一方面,是进一步提取它的语义,实际的过程要比这个更加复杂一些,我们有时候还要把它进一步整合,才能提取进一步的信息。

图1 人脑语言加工的双通道模型

除此之外,还有不同的语言加工过程,既包括语义的部分,也包括句法的部分以及一些其他的部分。而这个“其他”是特别值得关注的,虽然在图示中没有体现,但在最近几年却是被认知科学极大强调的一个部分,也是我觉得人脑去处理语言和自然语言处理(natural language processing,NLP)算法处理语言差别非常大的一个部分。

举个例子,如果当下我在这个地方瞬间静止下来,大家脑袋里会蹦出来很多词——这就是脑补的过程。这说明我们任何一个人在听一句话的时候,其实和自然语言处理中的大部分算法是不同的。我们并不是简单地去进行感知以及对输入进行被动处理,而是在非常主动地进行预测。心理学中常常讲到一个叫自上而下(top-down)的概念。所谓自上而下就是一种预测,而且这种自上而下可以来自很多不同的方面,比如经验、语言本身等。预测就是目前人脑和机器处理语言的最大差别。

那接下来的问题就在于,知道了大脑是怎么工作的,我们又如何把它跟自然语言处理联合起来呢?也就是要回答:认知神经科学和人工智能,在语言加工的领域中是否可以联结。

脑科学领域有很多不同的层次,它的尺度从遗传学到细胞、神经元,继而到环路,再到脑网络和系统,以及脑区。而人工智能领域也有不同的分类,比如自然语言处理领域可能会更希望受到人脑结构启发,也有很多不需要受到人脑结构限制的人工智能,只要给它足够多的GPU(graphics processing unit,图形处理器),具备足够好的运算性能,就能从算法上对这件事情做改进,并不需要受到人脑的结构启发或者认知科学的启发。

我们并没有刚性的需求要把脑科学和人工智能这两个领域联系起来。从人工智能自然语言处理的角度来说,我们需要做的是把脑科学中系统层次的脑区、脑网络,以及非语言能力的神经机制和自然语言处理中(例如“问答”,即question answering,QA)那些需要受到人脑结构、人脑功能启发,或和人打交道的部分联系起来。这个时候我们都会面对一些同样的问题,也会发现脑科学中我们现在尝试去解决的问题,也是人工智能现在正在关心、希望能解决的问题。

前文谈到很多研究在系统层次上希望把认知神经科学和人工智能联结起来,为什么是“认知”神经科学呢?因为对于自然语言处理或者对于想回答的问题来说,它更多是功能或任务相关的,抑或是“认知”相关的。例如,我会有怎样的行为所要关心的并不是神经科学里面那些大脑的灰质和白质,又如我需要飞,我需不需要长得像飞机?显然,这并不需要,我们需要的是软件层面和机制层面上的解释。

近5年以来,整个认知神经科学将注意力集中在动态网络和机制层面的研究。比如近年来,很多人在这个领域做的研究,就是用多尺度的成像方法把大脑的大小或者脑区跟脑区之间的联系给呈现出来。这个研究之所以重要,是因为我们要讨论大脑是怎么作为一个整体工作的,这类工作需要多个脑区之间的协同,那我们就想知道这个协同的联结基础是什么。我们常常说任何软件的基础其实都是硬件,而大脑的结构以及结构的连通性(白质纤维束),就是大脑功能网络的“硬件”基础。在“软件”层面上,我们可以关心神经递质,也可以去关心脑功能网络等。

我们有一系列从磁共振原理发展出来的不同的方法,可以去研究大脑多个层面上的机制。另外比较常用的方法就是脑电和脑磁。而这些方法的基础主要分为两类:第一类,是基于神经元活动的能量消耗;第二类,是基于神经元的电活动。大脑活动中很大一部分是神经元的活动,神经元活动时需要能量,最主要需要氧和葡萄糖。功能性磁共振和功能性近红外脑成像,其实就是看大脑哪个区域在活动。随着局部脑活动对氧的消耗,会不停地有新鲜的氧合血红蛋白涌入,这时候这里的氧的水平就高了。所以我们可以通过氧合血红蛋白和脱氧血红蛋白一个抗磁性、一个顺磁性的特性,用功能性磁共振影像来判断特定区域的氧合水平是不是变高了,以此判断这个地方是不是在活动。另外一类就是脑电,这一类方法直接去观察大脑中神经元的放电活动。

研究语言的神经科学家常常同时采用来自脑电和来自磁共振这两种不同的信号对语言的神经机制进行系统性的研究,因为脑电的信号可以清晰地告诉我们什么时候大脑在工作,而基于磁共振的空间信号更多时候是告诉我们大脑哪些部分在工作。这些研究有助于我们理解不同脑区之间是怎样协同工作的。

在听到语言或看到文字的时候,大脑会同时进行一些不同的加工,这些加工包括和语言相关的句法及语义,大脑还非常擅长用不同频段上的振荡来处理语言加工。从时间线上,我们一般会在接收到信息后的200毫秒内完成跟输入有关的部分,在之后的200~300毫秒里,我们都在进行加工的工作。这个加工的部分完成了几类并行的工作,包括单个词句内的关系结构处理,以及对较长时间里面的上下文关联信息进行加工等。

工作记忆是一个比较经典的心理学模型。这个模型表示在处理任何一件事情的时候,大脑的中央处理器既管语音的部分,也管视觉处理的部分,还需要管理前后相关事件的缓存,然后把它们整合在一起来实现工作记忆。最近的研究提出了一个新的模型,叫作内存系统(memory of system)模型。在这个模型中我们认为大脑的不同部分其实是在对信息进行层次化、结构化的加工。这些模型都在帮助我们去寻找那个真正的大脑运作机制。

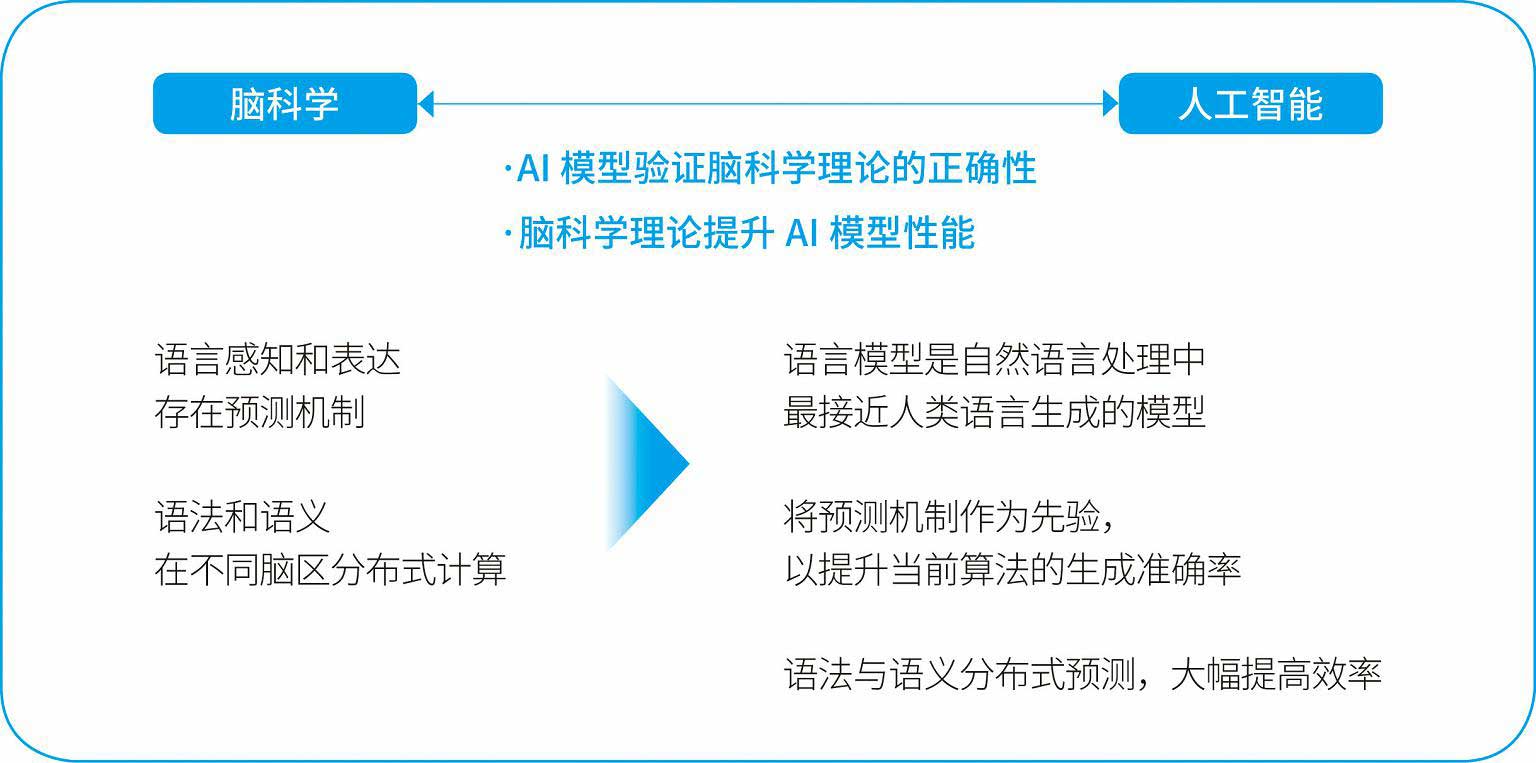

借用一位同事,纽约大学戴维·珀佩尔(David Poeppel)的话来说:组装汽车的时候有很多的零件,看到这些零件就像我们看到那些大脑活动一样,问题在于我们应该怎样把它们拼起来。这其实就是我们会主动地去接触研究自然语言处理和人工智能学者的原因。我们希望把认知科学和人工智能的框架结合起来,产生一个真正的模型来回答大脑的工作机制问题。而我的另一位合作者张铮教授团队的工作就受到脑科学理论的启示,提出了一个双路人工智能语言模型,如图2所示。他借鉴了一个认知科学模型里的概念——预测,也即在任何一个时候大脑都在不停地预测。

图2 受脑科学启发的双路人工智能语言模型

其实,大脑中会同时做出两种预测,既包括语义预测的部分,也包括句法预测的部分。例如我说了一个动词以后,大家可能会期待我后面讲一个名词或者名词短语(例如,踢——球),如果我用了一个词性不对的词(踢——跑步),可能就会引起听者的困惑。而如果我说“我正在和一群苹果分享我的研究”,大家立刻就会惊讶,“她是指自己在和苹果讲话?”(苹果虽然是一个名词,但明显不是可以交流的对象)。这个其实也是儿童在语言学习的过程中会犯的不同类型的错误,因为儿童比较容易习得语义,但是在句法上他们会习得得较慢。

在图2这个语言模型中,增加了语法和与语义的双重预测步骤之后,模型的性能提升了40%,这是一个让人震惊的发现。当然这个可能还只是一个非常简单的脑科学启发人工智能语言模型的例子。人类大脑工作的机制事实上远比这个更加复杂。预测和纠错机制、注意力、记忆力、短期工作记忆、长期工作记忆等都是我们领域中研究的对象,这些研究的成果都可以用于自然语言处理。

可以和大家分享一则趣事。埃隆·马斯克最近公布了他的重大发现,把脑机接口(brain computer interface,BCI)的芯片放到小猪身上,然后就可以听到猪鼻子去碰东西的时候发出的“哒哒哒”声。这个发现在业界非常轰动,因为它可以低成本高效地实现脑电探测的过程。但是有意思的是,这并不是一个新的发现。2000年一位神经科学家在他的推特上发布过一个非常轰动的发现——人造眼睛可以让盲人复明,但是事实上最终并没有成功。因为只是监测到神经元的活动的话,本身的意义不大。70多年前,就有学者做过相关的研究,也是我们这个领域在猫的身上做视觉研究的一项最早记录。实验中,在猫面前呈现横的或者竖的信号,就可以探测到“吧吧吧”的脑电波声音。这个70多年前的研究,从某种程度来说跟马斯克现在做的这个多通道BCI的研究有异曲同工之妙。

一个重要的问题是我们不只要知道这个信号,还要知道这个信号意味着什么,这也是脑科学和人工智能共同面对的一个问题,也即表征。例如,香蕉是黄的,“香蕉”和“黄”对人而言是一个非常直接的联系。然而,没有人会说“黄香蕉”,也很少有人会说香蕉是黄色的,所以这个潜在的联系对计算机来说就不一定会习得。还有很多方向性的信息,例如触电会导致死亡,所以触电跟死亡有一个指向性的关系。但是在说死亡的时候,大部分人并不会想到触电,所以词和词之间还存在一些因果的指向性关系。

其实词与词的关系远比这些更为复杂。在NLP领域,对语言的表征主要是基于语料库的向量空间嵌入模型,称为“外部语言模型”。同时人脑中基于实验也有一个联结模型,称为“内在语言模型”。

内在语言模型可以通过“词汇联想”来建立,就是让一个人在看到一个词的时候,告诉我们他联想了什么。目前我们通过5万多人的数据就可以知道在人脑中词和词之间的联系,并在这个基础上形成图,然后在图上去抓取单个词的表征,以及词和词的关系。我们一旦收集了这两者信息以后,就有很多不同的方法把它们联系起来。进而,我们希望有一些方法可以在大脑上印证。“外部语言模型”和“内部语言模型”并没有优劣之分,我们相信两者在大脑的不同层面上都会有所体现,并且反映出一些不同的特征。

这些研究可能会给我们的自然语言处理提供很好的基础,在这个基础上我们可以取得一些比较有效的表征。这个表征会比我们基于语料的向量空间获得更进一步的收获,在这个层面上我们可以去考察词和词之间的多维度关系,除了狭义的语义维度,也可以与情感维度、空间可想象性等各个不同的模态相关。也即,词的表征不光是在狭义的语言维度,还会涉及很多与视觉、运动、记忆等相关的维度,这些与认知科学关心的“具身认知”有关。我们希望通过这样的工作,给自然语言处理提供更好的研究基础。

目前,人工智能领域的神经网络借鉴了神经科学中一些神经元层面的概念,但经过一些年的摸索和尝试,我们认为至少在自然语言处理领域,脑科学或者说认知神经科学的研究和人工智能的研究更多会在系统层面有更深入的结合。在未来几年里,我们会更关心表征和计算两个研究方向,也会更多地关注预测。

我很喜欢认知科学家迈克尔·加扎尼加(Michael Gazzaniga)的一句话:“除了薄薄的一层当下,我们生命中的一切都是记忆。”可想而知,在我们的语言或者生活中,记忆对于任何高级认知能力甚至一些感知觉加工来说,都是非常重要的。我们既往的经历也无时无刻不在为预测提供重要的条件。

Q 我看了一篇文章,说“认知科学学科边界比较模糊”,那么如何定义认知,未来认知科学的研究内容和边界是什么?

A 我觉得“认知科学学科边界比较模糊”主要是指,它是一个非常跨领域的学科,或者学科群。它结合了刚才我们说的神经科学、人工智能,以及心理学、科学哲学、人类学、语言学等不同的领域。从定义上来说,“认知”指人类通过思想、经验和感官获得知识和理解的心理行为或过程,包括知觉、记忆、注意、判断、决策、语言等。所以从某种程度上说,研究人类如何进行信息加工的学科都属于认知科学。

认知科学在过去一些年中迅猛发展、受到瞩目的一个主要原因在于随着无损影像学的发展,脑科学或者说(认知)神经科学在系统和脑区、脑网络层面上做了大量工作。神经环路等方面的工作近年也有很多新的推进,但大部分是在模式生物上面做的,比如啮齿类动物(大鼠、小鼠等)、灵长类动物,但因为常常需要做有损的研究,所以很难应用在语言这样的高级认知上,因为它是人类所特有的,我们不太可能在人的身上使用有损的方法。大家也一直在积极地寻求一些新技术、新方法,可以在人作为模式动物的层面上去回答这些问题,或者设计一些以无损的方法来研究高级认知能力的机制,比如发展新的影像学方法以及设计模型和算法。认知神经科学只是认知科学的一小部分,在认知科学发展史上,人工智能和哲学、语言学等都对这一学科的发展起到了非常重要的推动作用,而认知科学的发展又正在反哺这些学科。认知科学的研究内容大多关注人类心智,如了解心智的表征和计算其怎么在脑中实现,如何进化、如何发展,并且进行某种程度的模拟(类脑)。这里面包含了无数等待我们去了解的题目,记忆也好,决策也好,意识也好,我们现在知道的都只有微不足道的一点点,还远远不能回答它们真正的机制。每个问题又从发展、进化、人工智能模拟的角度展开,生出很多理论问题或者技术课题。智力、语言和意识大概是其中最具有挑战性的几个问题。

Q 计算机有带宽和并发,请问人脑能并发处理吗?神经元怎么实现这些复杂的认知功能?

A 这是一个非常好的问题。近年已经有大量的研究证明我们的脑在很多不同层面上都在进行并行加工。举个简单的例子,在大尺度上,我们的语言处理基本上在左半脑,而视空间处理基本上在右半脑。我们先前的工作也发现有一小部分人(都是健康人)的语言系统在右半脑,而这些人的视空间处理主要靠左半脑。有极个别两个功能都在同一侧的人,他们执行语言—空间双任务的表现就会弱一些,这可以说是左、右脑的某种并行处理。如果说左、右半脑的这个例子太粗略的话,在视觉、听觉和几乎所有高级认知能力中,都存在大量的并行加工,既有对不同频率信息的加工,也有对信息的不同属性的加工。我们想想“一心二用”,大家在听我讲的时候,可能也会在旁边做一些别的事情,并且把这些事情处理得很好。这里牵涉很多认知功能的并行处理和整合。并行处理的机制究竟是怎样的?并行处理的瓶颈在什么地方?这些也是我们非常关心的问题。但这是一个非常不容易回答的问题,如果去深思的话,就会发现这几乎涉及认知神经科学的各个领域。它包含了神经元群体怎样进行运算和预测,怎样完成同步等。对于这些机制的了解,目前还在起步阶段,它们是各国脑计划关心的重要问题。我们知道脑活动主要是神经元在接收、整合、传递信息,信号传递是通过电或者化学信号来完成的。大家比较了解的脑电,测到的就是按相同方式整齐排列并且被同步激活的大量神经元的突触后电位。神经元活动也需要氧和葡萄糖,功能性磁共振看的就是局部脑区氧合水平改变引起的信号变化,据此来推断这里的神经元活动。那么看到这些神经活动够不够呢?戴维·珀佩尔教授就提出了一个很重要的问题,他称作“map problem VS.mapping problem”(图像问题VS.映像问题)。前者是关于精确地测量脑的不同形式的活动,包括它的时空信息;后者则关心怎样建立从认知的不同基本元素和运算到不同层面的神经活动的映射,或者说怎样去建立一个具有解释和计算能力的模型来解释这些神经活动。以语言为例,语言学或者认知上可以列出的音节、语素、短语等“元素”,在神经基础上能否找到某些神经元、神经元集群、皮层功能柱等和它们存在某种映射关系;进而,词和词的结合、句法生成、语义整合等这些认知“操作”是否有可能在一些神经活动比如LTP(长时程增强)、神经振荡、同步等层面上找到一些对应的关系。这就牵涉大量具体的系统性工作,也受限于方法和数据,目前能做的工作还非常有限。

另一方面,并不是所有研究者都觉得这是唯一可行的思路。有一些大家可能了解得不多但非常重要的工作,比如关于神经振荡或者神经递质的研究,它们从不同侧面或者不同层次来研究神经元活动或者信号传递。神经振荡是近年认知神经科学领域的一个热点,它关心的是我们脑的节律性神经电活动,或者说神经元集群的兴奋性水平周期性变化。近年大量研究表明,不同频段的神经振荡与特定认知功能有紧密的关系,比如alpha频段与注意抑制和选择,或者gamma频段与特征整合等。值得注意的是,这些不同频段的神经电信号还可以形成跨频段耦合,完成更复杂的认知任务。我们暂时对神经振荡是怎么工作的还没有足够系统的了解,但我觉得这个领域可能会产生一些突破性的工作。有一位我觉得对我很有启发的研究者盖伊尔吉·布萨基(György Buzsáki),他在这个领域做了很多重要的工作,最近出了一本新书《由内而外的大脑》( The Brain from Inside Out ),这本书提出了一个很有意思的视角,就是不像我们一般的由外到内的研究,关注大脑对信息的编码和表征,而是“站在脑的角度思考”。因为脑不关心“客观存在”的概念或者表征,其关注的是对信号进行整合,调动身体作出反应,来和当前情景交互,这才是“脑”认识世界的方式。如果大家有兴趣的话,可以读一读这本书。

我觉得大家问的问题非常好,我也希望几年之后,如果这一领域有大的研究进展,能够跟大家再分享,并且可以更深入地回答这些问题。