近几年,计算机视觉领域中兴起了计算摄影学(Computational Photography)方向的研究,其宗旨是克服成像和显示设备的局限性,用计算技术为视觉世界生成内容丰富、逼真的图像,并使其符合人类视觉系统(Human Vision System,HVS)对客观世界的感知。如何使已获得的高动态范围的图像在低动态范围的显示设备上有效地进行显示输出已成为一个越来越重要的课题。此外,如何消除光照对颜色中色度的影响,得到一种与光照无关的颜色描述子也是计算机视觉领域的研究热点之一。如果能实现真实场景在计算机中的再现,将会给计算机视觉系统带来质的飞跃。

如果没有颜色,很难想象人类生活的现实世界会是什么样子。颜色不仅使大千世界多姿多彩,而且为人们提供了其他许多有用的信息,例如红色代表热情,绿色代表希望等。同时,颜色信息也方便了人们的日常生活,例如颜色使得公共交通可以有条不紊地进行,行人遵守着“红灯停,绿灯行,黄灯亮了等一等”的公共交通规则。自从牛顿在1704年提出了颜色的基本理论,颜色已经被许多不同领域关注和研究,如光学、物理学、心理学等。尤其近年来随着计算机视觉领域的蓬勃发展,颜色也逐渐成为研究的热点与重点。但是,颜色也是极不稳定的,很容易受到光照变化的影响。幸运的是,人类的视觉系统拥有颜色恒常性这一重要的视觉感知功能,它能消除(或者减轻)光照对颜色的影响,得到物体表面真正的物理反射特性。为了提高计算机视觉系统的稳定性,使计算机视觉系统也具有这种颜色恒常性的感知功能,计算机学者将颜色恒常性理论引入了计算机视觉,提出了颜色恒常性计算理论。

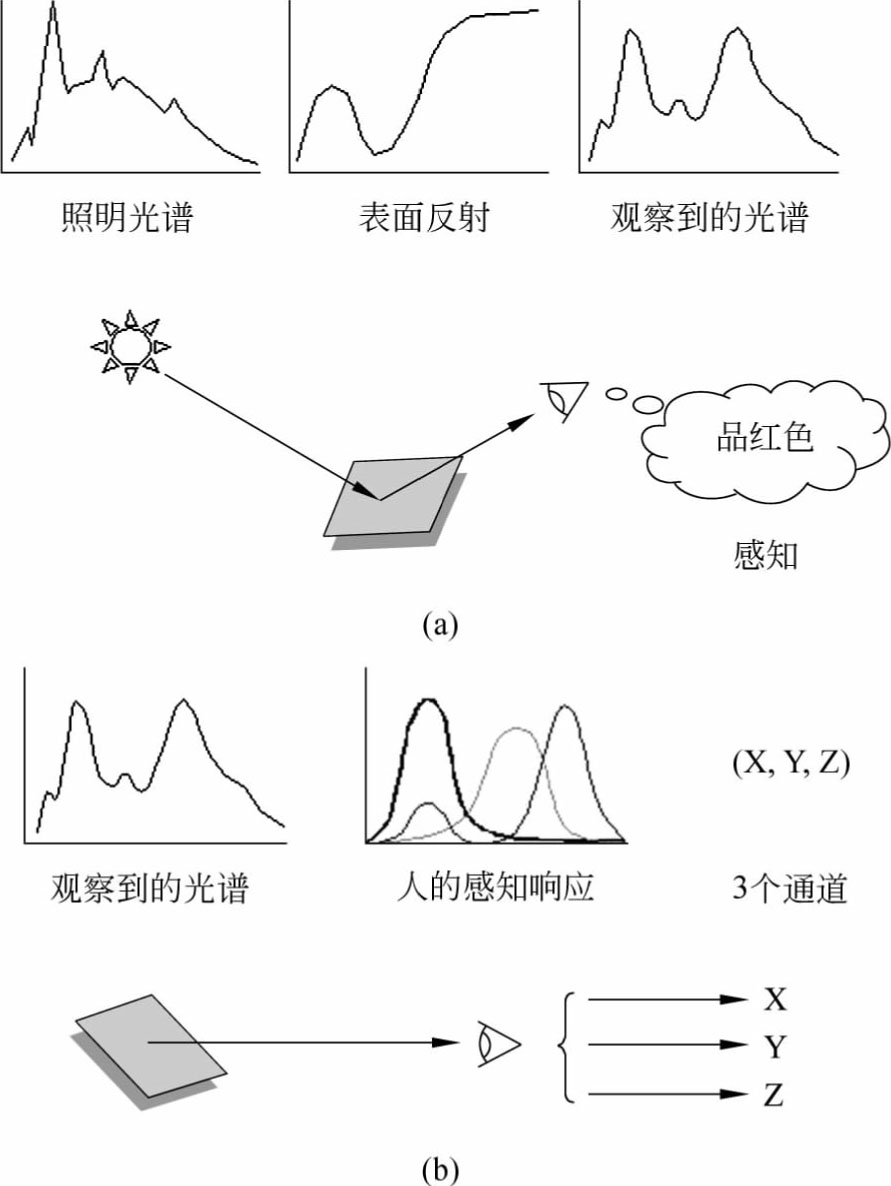

颜色是通过眼、脑和人们的生活经验所产生的一种对光的视觉效应。图1-1描述了人眼成像的基本原理。环境光照经过物体表面反射到人眼,人眼中有3种不同的锥状细胞,用来感知颜色:第一种主要感知红色,它的最敏感点在565nm左右;第二种主要感知绿色,它的最敏感点在535nm左右;第三种主要感知蓝色,其最敏感点在420nm左右。每种锥状细胞的敏感曲线大致是钟形的,因此进入眼睛的光一般会被分为3个不同强度的信号。因为每种细胞也对其他波长有反应,所以并非所有的光谱都能被区分,比如绿光不仅可以被绿色锥状细胞感知,其他锥状细胞也会产生一定强度的信号,所有信号的组合就是人眼能够区分的颜色的总和。

图1-1 图像中物体表面颜色的形成过程

(a)光线经反射进入人眼后,人感知物体表面的颜色;(b)3个通道的颜色信号

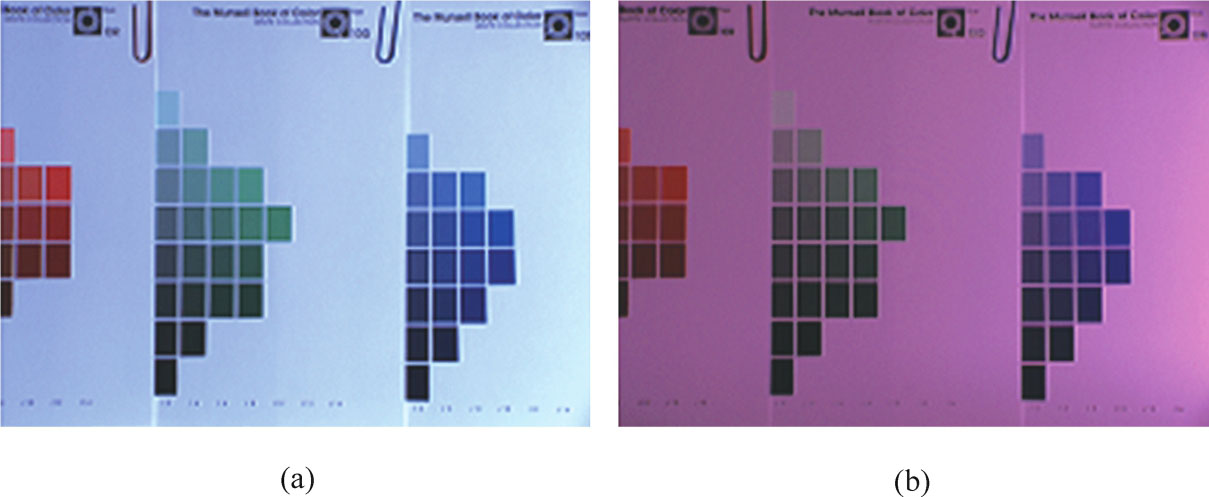

根据朗伯特反射模型,人眼、相机以及其他成像设备在获取图像时,至少依赖于3个方面的因素:成像时场景所处的光照条件、场景中物体表面的反射率以及成像设备镜头的感光系数。从图1-1中可以看出,3个方面的因素中的任何一个发生变化都会给最终的颜色信号造成很大的影响。一般地,如果忽略镜头感光系数的差异对颜色的影响,那么仍然存在光照这个外界因素会对图像颜色产生影响。对于同一物体表面,不同的光照可能会产生完全不同的颜色,因此颜色是一种极不稳定的视觉特征。但幸运的是,人类视觉系统对颜色的感知不仅由光的物理性质所决定。大量实验显示,不管所处的光照颜色如何变化,人眼视觉系统都能很轻松地识别出物体并实现对其表面颜色的恢复,这种能够消除或减轻光源影响并实现更精确地“看到”实际表面颜色的能力被称为颜色恒常性(Color Constancy)。人类的视觉系统所拥有的颜色恒常性能消除光照对颜色的影响,得到物体表面真正的颜色特性。如图1-2所示,同一场景在不同光照下拍摄的图像颜色差别很大,但是人类视觉系统可以辨别出这是同一个景像,不论它是在室内钨光灯下,还是在红色光照下。颜色恒常性使人类视觉系统能够稳定地感知物体表面的颜色。为了提高计算机视觉系统的稳定性,计算机学者将颜色恒常性理论引入计算机视觉,提出了颜色恒常性计算理论。颜色恒常性计算的目的是消除光照对图像颜色的影响,从而得到物体表面与光照无关的颜色特性,为计算机视觉系统提供类似于人类视觉系统的颜色恒常性感知功能。如果计算机视觉系统具有与人类视觉系统一样的颜色恒常性能力,能够提供稳定的颜色特征,那么许多棘手的计算机视觉问题就能迎刃而解。

图1-2 不同光源下同一场景的图像对比

(a)在钨光灯下拍摄;(b)在红色光照下拍摄

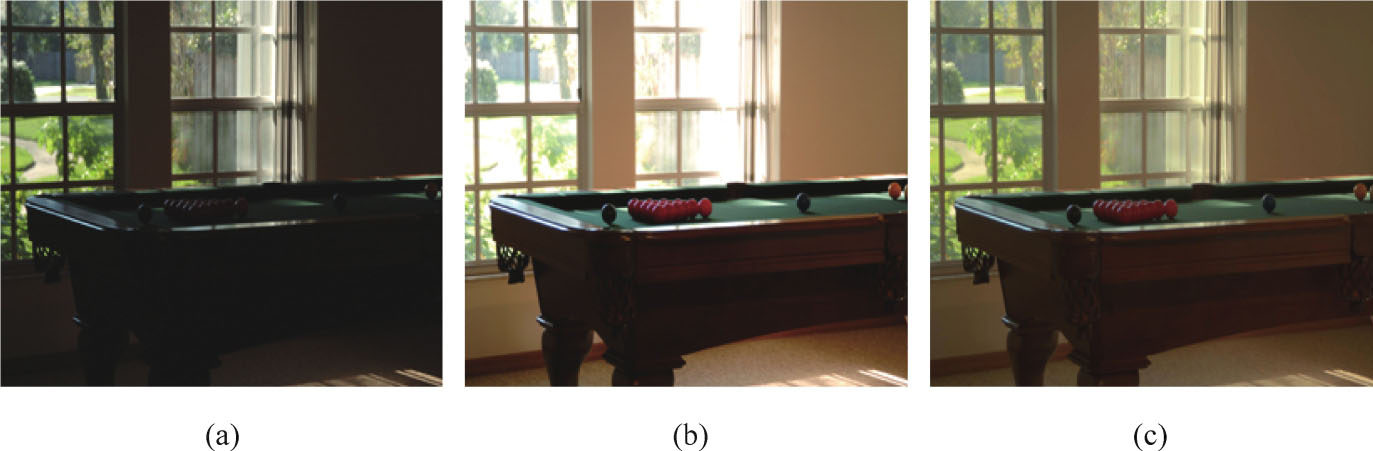

在日常生活中,当我们用传统相机在室内拍摄有阳光射入的门、窗等场景图像时,或对着太阳、灯光拍摄图像时,不管怎样调整相机参数,都会存在严重丢失场景细节信息的现象。如图1-3给出的典型场景示例,图1-3(a)表示采用低曝光度获得的图像,可以看出,室外树木的细节信息可以被人眼感知,但室内台球案的细节严重丢失。图1-3(b)表示同一个场景下用高曝光度获取的图像,虽然台球案的细节信息可以很好地表现出来,但窗外的树木信息丢失严重。图1-3(c)表示真实场景的信息。

图1-3 典型场景示例

(a)低曝光;(b)高曝光;(c)真实场景信息

为什么会出现这种信息严重丢失的现象呢?原因在于真实场景所展现的亮度范围超出了相机本身所能显示的动态范围。真实场景具有非常广的动态范围,比如从夜空中的星光到耀眼的太阳,这种场景亮度变化涵盖大约9个数量级(10 9 )的动态范围。但是,目前普通的显示/输出设备受到软硬件水平的限制,使得数字图像的存储、传输、处理、显示等都是基于8位二进制数进行的,只能表示256(约10 2 )个灰度等级,图像的亮度级别十分有限。正是由于动态范围的不匹配才导致了图1-3(a)和图1-3(b)的细节信息丢失。如何使获取的图像带给人眼的视觉感知与人们直接观察真实场景具有的感官体验尽可能相同,这一问题吸引了众多研究者的关注。为了解决这个问题,人们提出了高动态范围(High Dynamic Range,HDR)场景可视化技术,使该类场景能够在普通显示设备上得到最优化的再现。高动态范围场景指具有高于普通显示设备动态范围的场景。

在数字图像的成像过程中,真实场景、人类视觉系统和显示设备等都具有不同的亮度级别。亮度级别可以用动态范围定义,即图像的最大亮度与最小亮度之比。人类视觉系统和真实场景所具有的亮度动态范围要远远大于显示设备的动态范围。近年来,随着数字摄影和计算机软硬件技术的深入发展,在获取HDR场景信息方面已经取得了很大的进步,可以通过专用相机或者软件合成算法生成HDR图像。有研究者利用多幅同一场景不同曝光的图像序列,恢复成像系统的响应曲线,并获得相机曝光量和图像亮度值之间的映射关系,从而将上述多曝光图像序列合成一幅该场景的HDR图像。但是,现有的通用显示设备(如液晶显示器)仅能显示约2个数量级的动态范围亮度,这一状况由于受到硬件成本的制约,短时期内难以改变。所以,如何使已获得的HDR图像在低动态范围的显示设备上有效地显示、输出,即HDR图像的色调映射问题成为一个越来越重要的课题。

由于一组同一场景不同曝光度的图像序列要比单一图像能够提供更多的信息,较暗的照片可以提供场景明亮处的细节,而较亮的图像可以较好地显示暗处细节,因此可以分别提取每幅图像的有用信息,然后进行融合以得到一幅尽可能多地包含场景信息的高质量图像。所以,可以利用多曝光融合技术解决HDR场景可视化问题。

色调映射和多曝光融合技术作为本书主要研究内容,它们的共同点是:均采用了一组不同曝光度的图像序列作为输入数据源,目的都是通过一定的算法将不同曝光度下的图像细节融合到同一张高质量的图像中,并在普通显示器上显示,且要接近场景的真实内容,符合人眼的视觉感知。二者的主要区别是处理对象不同,色调映射处理的是由多曝光图像(一般需要成像参数)生成的HDR图像(采用浮点数进行存储);而曝光融合算法直接处理多幅具有不同曝光的图像序列,二者所采取的融合思路是完全不同的。经过色调映射算法或多曝光融合算法处理后得到的结果图像,不仅有助于人眼对场景的辨识,而且对边缘检测、图像分割、图像锐化等数字图像的后续处理和计算机视觉系统的研究也具有积极的意义。此外,在应用方面,HDR技术能够在复杂环境下获得更高质量的成像,在很多领域中也有极其广泛的应用前景,如高清影片、游戏特效、航空航天、卫星气象、医疗、印刷等领域。对HDR图像处理的研究不仅具有非常重要的学术价值,而且具有较高的经济价值和社会效益。